Storia ed evoluzione delle reti neurali

Il concetto di neurone artificiale affonda le sue radici nel 1943, quando gli scienziati Warren McCulloch e Walter Pitts propongono il primo modello teorico. La loro idea descrive un sistema capace di elaborare dati binari: ogni elemento riceve in ingresso un insieme di valori e produce un'unica uscita, operando esclusivamente su funzioni booleane di base.

Nel 1949, Donald O. Hebb introduce un principio rivoluzionario, ipotizzando che le macchine possano apprendere in modo simile al cervello umano. Questa intuizione getta le basi per i futuri sviluppi nell’apprendimento automatico e nelle moderne reti neurali.

L'evoluzione del Perceptron e l'introduzione delle reti multilivello.

Nel 1958, Frank Rosenblatt propone il Perceptron, la prima rete neurale artificiale funzionante. Con questa innovazione, l’apprendimento automatico diventa una realtà concreta. Il Perceptron è composto da uno strato di nodi di input e un singolo nodo di output.

Un aspetto fondamentale di questo modello è la presenza di pesi sinaptici dinamici, che regolano la forza delle connessioni tra i nodi. Questo meccanismo consente alla rete di apprendere, sebbene in modo rudimentale rispetto alle reti neurali biologiche. Il Perceptron segue un’architettura feedforward, in cui i segnali si propagano in un’unica direzione, dall’ingresso all’uscita. Tuttavia, la sua applicazione è molto limitata: può solo riconoscere forme e classificarle in due categorie distinte, oltre a calcolare semplici funzioni.

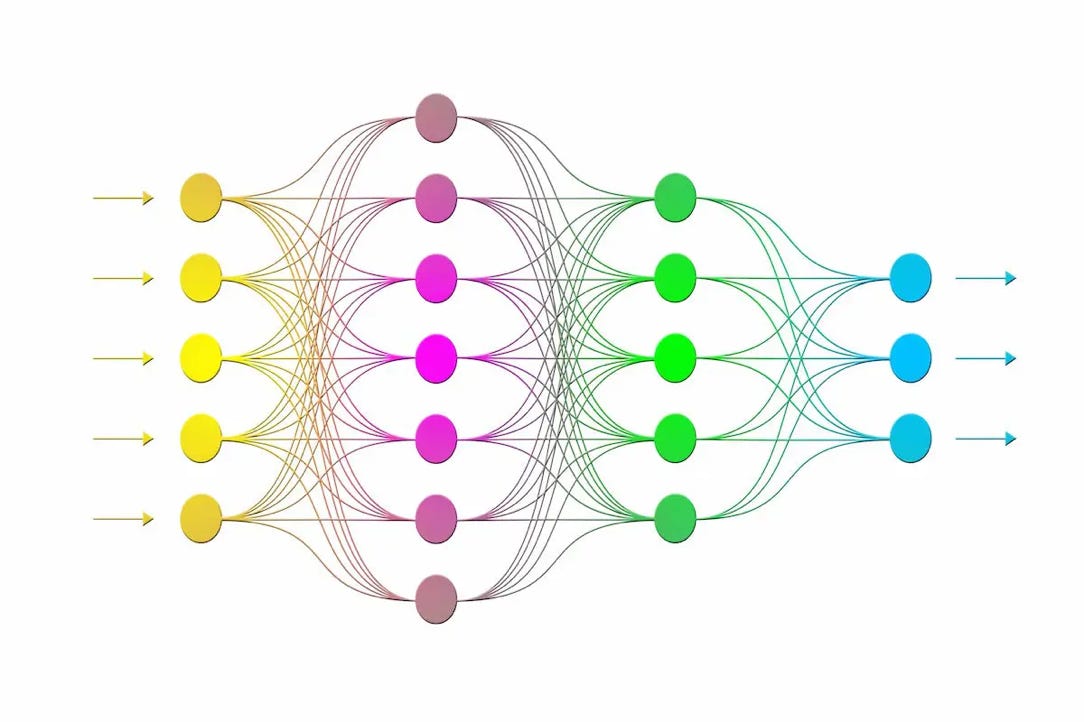

Un significativo passo avanti è rappresentato dal Perceptron Multistrato (MLP). In questa architettura, tra lo strato di input e quello di output si inserisce uno strato nascosto (hidden layer), dove avviene l’elaborazione delle informazioni. A differenza del Perceptron semplice, l’MLP è una rete non lineare e con connessioni multiple tra i nodi, il che gli permette di computare qualsiasi funzione.

Nel 1974, Paul Werbos introduce nella sua tesi di dottorato il concetto di backpropagation, un metodo che rivoluzionerà l’addestramento delle reti neurali multilivello, aprendo la strada agli sviluppi futuri dell'intelligenza artificiale.

L'algoritmo di retropropagazione e l'evoluzione del machine learning

Nel 1986, Rumelhart, Hinton e Williams riprendono e perfezionano il lavoro di Werbos, sviluppando il celebre algoritmo di Error Back-Propagation (EBP). Questo metodo, tuttora utilizzato, segna un punto di svolta nell’addestramento delle reti neurali.

L'EBP consente di migliorare progressivamente l’apprendimento automatico di una rete, regolando i pesi delle connessioni tra i nodi che non producono un output ottimale, fino al raggiungimento di un risultato soddisfacente.

Un contributo fondamentale a questa teoria deriva dal precedente lavoro di Donald Hebb, che aveva studiato le connessioni tra neuroni biologici. Hebb ipotizzò che il peso delle connessioni dovesse aumentare solo quando vi era una convergenza tra i segnali pre e post-sinaptici, un concetto chiave per la modellizzazione delle reti neurali artificiali.

Grazie al Perceptron Multistrato (MLP) e all'algoritmo di retropropagazione, il machine learning inizia a trovare applicazioni concrete negli anni ‘90, aprendo la strada ai moderni sviluppi dell'intelligenza artificiale.

L’evoluzione delle reti neurali: feedback, memoria e auto-organizzazione

Parallelamente allo sviluppo delle reti feedforward, negli anni ‘80 emergono anche reti neurali con architetture feedback, che consentono il flusso bidirezionale delle informazioni. Un esempio significativo è la rete di Hopfield, proposta nel 1982 dal fisico John Hopfield. In questo modello, i dati possono viaggiare in avanti, all’indietro e tra nodi appartenenti allo stesso livello, ampliando così le possibilità applicative delle reti neurali.

Negli anni ‘90 viene introdotta un'altra innovazione: la rete di Elman (1990), anch’essa un modello ricorrente e bidirezionale. A differenza delle classiche architetture MLP, questa rete include un insieme di nodi di memoria, progettati per conservare informazioni sugli stati precedenti della rete. Grazie a questa caratteristica, il modello di Elman si dimostra particolarmente efficace nell’elaborazione di sequenze temporali, risultando utile in applicazioni come il riconoscimento del linguaggio e l'analisi dei dati sequenziali.

Un altro passo avanti è compiuto nel 1982 da Teuvo Kohonen, che sviluppa una rete neurale con una combinazione di architetture feedforward e feedback. La peculiarità della sua rete, nota come Self-Organizing Map (SOM), è la capacità di ristrutturare autonomamente la disposizione dei propri nodi. I nodi con pesi simili tendono ad avvicinarsi tra loro, mentre quelli con pesi molto diversi si allontanano, dando vita a una mappa auto-organizzata. Questo modello è particolarmente efficace per la clustering e la visualizzazione dei dati, trovando applicazione in ambiti come la compressione delle informazioni e il riconoscimento di pattern.

Algoritmi di apprendimento nelle reti neurali

Nelle reti neurali artificiali, il processo di apprendimento è una versione semplificata di quello che avviene nelle reti biologiche. Pur non esistendo neurotrasmettitori, il principio di funzionamento rimane simile: i nodi ricevono dati in input, li elaborano e trasmettono le informazioni ad altri neuroni.

Attraverso cicli ripetuti di input-elaborazione-output, con dati di ingresso sempre diversi, la rete diventa capace di generalizzare e fornire risposte corrette anche per input mai visti prima, al di fuori del set di addestramento.

Gli algoritmi di apprendimento utilizzati per addestrare le reti neurali si suddividono in tre categorie principali, la cui scelta dipende sia dal campo di applicazione sia dall’architettura della rete (feedforward o feedback):

- Apprendimento supervisionato

- Apprendimento non supervisionato

- Apprendimento per rinforzo

Questi metodi permettono di adattare le reti neurali a diverse esigenze, dalla classificazione di dati all’ottimizzazione di decisioni.

Apprendimento supervisionato

Nell’apprendimento supervisionato, alla rete neurale viene fornito un training set, ovvero un insieme di dati di input con i corrispondenti output noti. Analizzando questi esempi, la rete apprende le relazioni tra input e output, sviluppando la capacità di generalizzare e di produrre risposte corrette anche per dati mai incontrati prima.

Durante il processo di apprendimento, la rete elabora output che vengono costantemente confrontati con i valori attesi. In caso di errore, i pesi sinaptici vengono aggiornati:

I pesi associati a output corretti vengono rafforzati, migliorando la precisione del modello.

I pesi che generano risposte errate vengono ridotti, affinando progressivamente le prestazioni della rete.

Questo meccanismo consente alle reti neurali feedforward di apprendere in modo efficace, rendendole adatte a compiti come la classificazione delle immagini, il riconoscimento del linguaggio e la previsione di dati.

Il ruolo dell’Error Back-Propagation e l’importanza dell’esperienza

L’apprendimento supervisionato fa uso dell’Error Back-Propagation (EBP) per ottimizzare i pesi della rete, ma il successo del processo dipende anche dall’esperienza dell’operatore che la istruisce.

Un aspetto critico è trovare un equilibrio tra le dimensioni del training set, la complessità della rete e la capacità di generalizzazione.

Se la rete dispone di troppi parametri e una potenza di elaborazione eccessiva, può sviluppare un modello eccessivamente specifico, incapace di riconoscere correttamente input esterni al training set. In altre parole, il sistema rischia di memorizzare i dati piuttosto che apprendere le relazioni generali, portando al fenomeno dell’overfitting.

Al contrario, se il training set è troppo ridotto o poco variegato, la rete non acquisisce informazioni sufficienti per generalizzare e fornire risposte affidabili su nuovi dati.

Trovare il giusto compromesso tra questi fattori è una sfida che richiede esperienza e conoscenza del problema da risolvere.

Le reti feedforward, come il Perceptron Multistrato (MLP), fanno ampio uso dell’apprendimento supervisionato per affrontare problemi di classificazione e previsione.

Apprendimento non supervisionato

Nell’apprendimento non supervisionato, la rete neurale riceve esclusivamente un insieme di variabili in input, senza che le corrisponda un output noto. Il suo compito è analizzare i dati e individuare autonomamente schemi e relazioni, creando cluster per categorizzarli.

Anche in questo approccio, i pesi sinaptici sono dinamici, ma la loro modifica avviene in modo autonomo, senza intervento esterno. Questo tipo di apprendimento è particolarmente utile per problemi di clustering, riduzione della dimensionalità e rilevamento di pattern nascosti nei dati.

Esempi di reti neurali che impiegano l’apprendimento non supervisionato includono:

Le Self-Organizing Maps (SOM) di Kohonen, capaci di auto-organizzarsi in base alle caratteristiche dei dati in input.

Le reti di Hopfield, che funzionano come sistemi di memoria associativa, immagazzinando e recuperando informazioni in base ai pattern appresi.

Apprendimento per rinforzo

Nell’apprendimento per rinforzo, la rete neurale non dispone di associazioni input-output predefinite, né riceve correzioni esplicite sugli output da generare. L’apprendimento avviene esclusivamente attraverso l’interazione con l’ambiente, eseguendo una serie di azioni e valutandone gli effetti.

Il principio di base è semplice:

Le azioni che avvicinano la rete all’obiettivo desiderato vengono rinforzate, aumentando la probabilità che vengano ripetute.

Le azioni che portano a errori vengono scoraggiate, riducendo il loro impatto nelle future decisioni.

In sostanza, un algoritmo di apprendimento per rinforzo guida la rete neurale verso il risultato ottimale attraverso un meccanismo di incentivi (azioni positive) e disincentivi (azioni negative), migliorandone progressivamente le prestazioni. Questo approccio è ampiamente utilizzato in settori come la robotica, il gaming e l’ottimizzazione di strategie decisionali.